“L4自动驾驶汽车元年即将在2024~2025年左右出现,届时市场上会出现大量能够实现大规模应用的L4自动驾驶汽车产品。”

9月2日晚,在《中国汽车报》与广州智能网联汽车示范区运营中心联合推出的“2020智能网联汽车精品课”第20讲中,广汽研究院智能驾驶技术部负责人郭继舜以“自动驾驶量产的视觉感知技术”为主题,详细探讨了L4、L3、L2.5、L2、L1级自动驾驶传感器配置方案及视觉感知技术,以及量产难题和未来趋势。

■为满足功能安全的要求,量产车型至少需要两种以上异构传感器

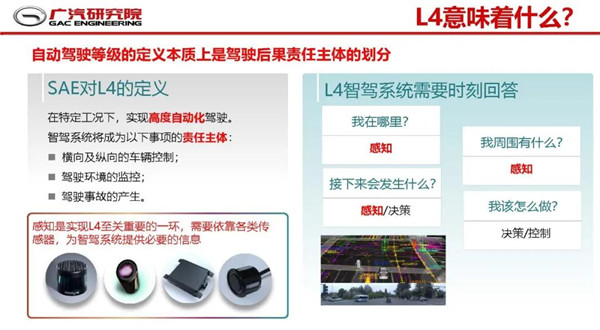

“自动驾驶等级的定义本质上是驾驶后果责任主体的划分。”郭继舜表示, L0~L2的辅助驾驶,驾驶事故责任主体均为驾驶员,而L3~L5的自动驾驶功能,特别是L4和L5高级别自动驾驶,因环境感知、车辆自主决策、横纵向车辆控制等导致驾驶事故的责任主体都是智能驾驶系统。

感知系统是实现自动驾驶至关重要的一环,需要依靠各类传感器来提供必要信息,而且自动驾驶等级越高,对感知系统的要求也越高。从技术角度分析,L4级自动驾驶需要多传感器融合,例如,Waymo所选用的L4传感器方案在业内比较有参考性,其以高线束激光雷达为主要传感器来获取三维空间信息,使用多摄像头视觉系统来获取色度信息,同时辅以毫米波雷达在近距离内完成识别、泊车等工作。毫米波雷达可以在雨雾、黑夜等复杂情况下获取精确的目标运动状态,对于激光雷达是一个有效的补充。

与之略微不同,广汽选用的L4传感器方案包括高清摄像头、激光雷达、毫米波雷达、超声波雷达和鱼眼摄像头。尽管传感器选型和布置与Waymo不尽相同,但整体思路不谋而合,即利用不同传感器的不同属性,实现对驾驶工况的全覆盖,并形成传感器间信息的安全冗余。

那么,如果拿掉一到两个传感器会怎么样?郭继舜指出,大多数场景下车辆仍能行驶,但基于现有功能安全的需求,量产自动驾驶车型必然要进行多传感器的异构冗余设计,车上至少要有两种以上异构传感器来提供准确感知。具体来看,高线束激光雷达+多摄像头的主传感器配置方案短期内不会改变,激光雷达感知距离,摄像头识别物体。

■视觉为主的L4,目前尚不能满足量产车型对功能安全的要求

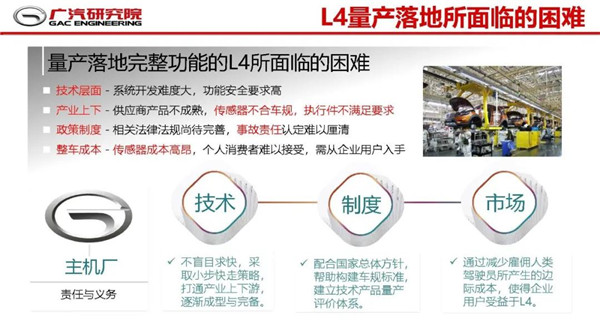

郭继舜表示,目前L4还处于测试验证和后装阶段,量产落地还有很多障碍。技术方面,系统开发难度大,功能安全要求高;产业链方面,供应商产品不成熟,车规级传感器、执行件还不够成熟,无法满足大规模量产要求;政策方面,相关法律法规尚待完善,事故责任认定难以厘清;成本方面,传感器等关键零部件成本高昂,个人消费者难以接受……

他预计,如果上述问题得到解决,2024~2025年左右会出现很多批量化生产的L4级自动驾驶汽车,不过届时很可能会首先卖给共享出行公司,例如滴滴、Uber等。

郭继舜还指出,车路协同,特别是5G V2X技术,将有助于推动L4的商业化,车载以太网是必然。通过车路协同感知,可将部分车端感知转移到路端,将有效降低车端对传感器、芯片、功耗、感知算法等的要求。而且,车路协同感知能获取单车感知系统无法获取的盲区信息、超视距信息等,极端环境下的感知性能优良,能够获得交通参与体的精确位置、速度以及意图。根据美国交通部的数据,V2V技术可帮助预防80%各类交通事故的发生。

那么,视觉为主的L4是否可行?郭继舜给出了否定的答案,仅依赖视觉感知目前是不能满足量产功能安全要求的。理由是仅依靠摄像头,感知不准确,像AEB(自动紧急制动系统)、ACC(自适应巡航系统)等纵向功能识别不好,功能安全整体小于ASIL B(汽车安全完整性等级B);再加上与融合方案相比,要达到相同的感知性能,单一视觉方案需要的算力更大;此外,即使有大量摄像头,极端情况下依然会出现问题,逆光/阳光直射等情况很难彻底解决,因此还需要用到激光雷达等其他传感器。

■1V1R低成本方案适用中配走量车型

据郭继舜介绍,与L4相比,L3可以视觉系统为主要传感器,同时配合高精地图使用,而量产车型基于功能安全考量,还需要激光雷达,可以是低线束。“高精度地图在L2.5~L4一定是必要的。”他强调。当然,出于成本考虑,传感器配置会有变动。

“现有的视觉算法对AI芯片依然是很大的挑战,需要创新的算法。现阶段我们预计L3自动驾驶需要30~40 TOPS。”郭继舜表示,现有芯片只有极少数能达到这个水准,而华为芯片值得期待。V2X的使用也会有很大的帮助,可以减少视觉的运算量。

再看L2.5,它是L2与L3的折中之举,这个级别驾驶责任主体仍是驾驶员。郭继舜介绍道,主要有两种风格,一种以传统车厂通用Super Cruise传感器方案为代表,允许脱手,但眼睛要一直观察路面;还有一种是特斯拉AutoPliot传感器方案,以视觉系统为主,同时为侧向进行了全范围的感知冗余,功能通过OTA不断升级,但不允许脱手。

至于L1和L2,量产化方案已经颇多,典型配置是一个前向摄像头加一个毫米波雷达,即1V1R。如果要降低成本二选一,则郭继舜倾向于保留摄像头。

目前,不少量产车使用双目解决方案,但与单目相比成本高一些。那么,双目视觉是不是好的量产选择?“是,双目有着独特的价值,深度感知更准确,误差小,且能更好识别未知物体。”郭继舜说。

他指出,在L1/L2的ADAS方案中,摄像头为主要传感器,充分利用多种CV算法交叉验证;双目在中短距离有更好的表现,但硬件成本有所增加,基于Mobileye的良好表现,OEM会考虑降本需求;相比于双目的成本增加,可能1V1R的性价比更高;毫米波雷达虽然维度单一,但鲁棒性好,在保证功能安全上将长期发挥作用;充分利用1V1R等低成本方案对功能进行充分挖掘将是中配走量车型的趋势。

在DMS(驾驶员监控系统)中,视觉是主要感知手段,辅以红外、舱内毫米波雷达等。L3层面DMS主要用于监控驾驶员状态,到了L4层面DMS更多是提供服务。

精彩问答

在讲座之后,郭继舜还与网友进行了问答互动。记者撷取精华,以飨读者。

Q:虽然自动驾驶有分级,但依靠现在的技术,是否有可能直接从L3甚至L4起步?

A:有意量产的汽车厂商无法规避L3,但科技公司如果只想做L4的算法,则可以从L4起步。

Q、L1~L2所用的传感器,是否可以应用于L3或L4?为何说,L1~L2解决方案过于同质化?

A:可以用一部分,但L3和L4所需传感器更多。L1~L2解决方案趋同,说明业内已经找到了性价比较高的公认模式。特斯拉给业内的启示是:软件个性化,硬件通用化;软件模块化,硬件标准化。通过软件为汽车赋能,使得产品更加有个性。

Q:随着自动驾驶向高级别进化,视觉感知、毫米波雷达、激光雷达等传感器的发展趋势是怎样的?会有轻重之分吗?

A:精度越来越高,接口逐渐统一,性能越来越强,成本越来越低,激光雷达的降本希望很大。在L3以下,视觉是主要传感器方案;在L4及L5,视觉和激光雷达共同形成的带有RGB信息的点云成为主要感知信息。

Q:L4以上的自动驾驶,是不是一定要用5G联网,在高级别自动驾驶上5G的优势是什么?能够解决哪些方面的问题?

A:不一定,但基于5G的V2X可以提供更稳定的信息,提升安全性。5G能够让人看到遮挡物体以外的信息,同时减少识别难度和时间。现阶段,任何时候我们都不能抛弃单车的感知和决策,车路协同只是参考。

Q:L4以上高级别自动驾驶中,对数据处理、数据安全、算力等要求更高吗?具体表现在哪?

A:要求更高,难度更大,所以需要车载以太网。我们预计,L4自动驾驶每小时所产生的原始数据约为4TB,很大,因此对数据处理和算力和要求非常高。数据安全方面,由于L4以上不再需要驾驶员,因此对数据和网络安全要求更高,以保证其不被黑客劫持。

Q:高级别自动驾驶对于软件的要求是否有提高?是否能体现软件定义汽车?

A:是。场景更多、更复杂,软件的难度和要求都在提升。未来硬件会逐渐同质化,但通过软件可以使得每个人的车都不一样。

Q:车联网在高级别自动驾驶中作用如何?

A:车联网能够给车辆提供更多信息,有些信息通过单车智能无法获取。

Q:除了车路协同,高级别自动驾驶还需要哪些信息或设施的支持?

A:RTK,即差分的GPS。期待未来有更多信息交互方式出现。

Q:卫星导航是通过什么方式支持自动驾驶?

A:通过GPS让车辆时刻知道在哪里,当然这个误差有点大。还需要惯导、视觉系统等将定位精度控制在正负20~40厘米左右。

Q:在信号不佳的情况下,自动驾驶通过什么判断?

A:我们不会开发一辆只会依靠5G网络才能跑的车。即使信号不佳,单车也能有很好的自动驾驶能力。

编辑:黄霞